英特尔推出针对PC软件的AI加速计划

英特尔与100多家软件开发商合作开发300多项人工智能加速功能的原因很简单:英特尔在其用于笔记本电脑的第14代“流星湖”酷睿超芯片中引入了人工智能功能,它需要它们做一些事情。

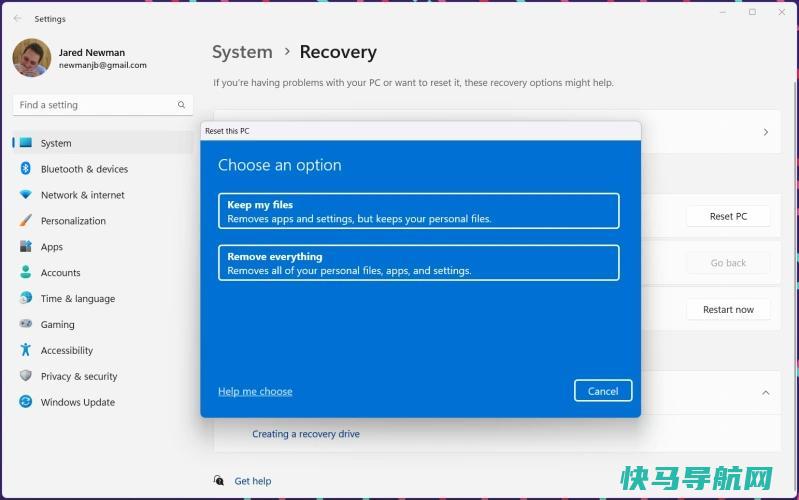

这不是在开玩笑。人工智能已经成为必应聊天、Google Bard、Windows Copilot和 Chatgpt 的代名词–所有这些人工智能工具都生活在云中。英特尔新推出的人工智能加速计划,预计米特湖将于12月14日正式推出,将试图说服消费者,人工智能应该在他们的电脑上本地运行。

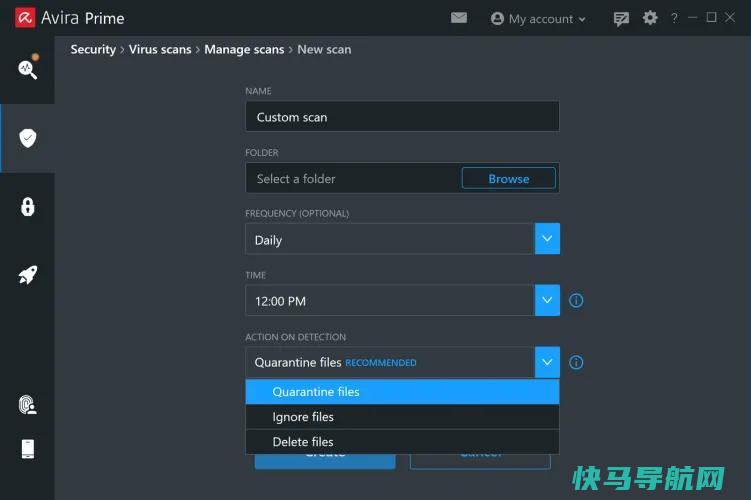

这可能很难向消费者兜售,因为他们可能不知道–或者不关心–这些功能是在哪里处理的。然而,英特尔却不顾一切地这样做–并试图在其英特尔创新大会、收益报告和其他方面传达这一信息。英特尔正试图鼓励开发人员要么为英特尔的人工智能引擎NPU编写原生代码,要么使用英特尔帮助编写但已作为开源发布的OpenVINO开发工具包。

这些开发人员不一定会公开宣扬他们软件的所有人工智能功能。但英特尔确实强调了几个未来的开发人员:Adobe、Audacity、BlackMagic、BufferZone、CyberLink、DeepRender、MAGIX、倒带人工智能、Sk目、托帕兹、视频通信、Webex、WonderShare Filmora、XSplit和Zoom。

然而,只有少数开发人员呼吁提供特定的人工智能功能。深度渲染公司使用人工智能来压缩文件大小,该公司联合创始人兼首席执行官克里·贝森布吕赫在一份声明中表示,人工智能将允许他们的算法处理比平时多五倍的视频压缩。使用人工智能来升级照片的黄玉实验室表示,它可以利用NPU来加速其深度学习模型。

XSplit开发了一款用于移除和操纵网络摄像头背景的VCAM应用程序,该公司还声称可以利用NPU来获得更好的性能。XSplit首席执行官安德烈亚斯·霍伊表示:“通过利用在英特尔和NPU上运行的更大的人工智能模型,我们能够将现场视频的背景去除误差降低高达30%,同时显著降低CPU和GPU的整体负载。”

然而,其他许多人表示,他们只是将NPU视为另一种可以利用的资源。事实上,这与英特尔在这个问题上的观点是一致的:虽然NPU可能是加速特定AI功能的最省电的手段,但NPU、GPU和CPU的组合可能是尽可能快地完成任务的最佳组合。

一些开发人员可能也会将本地处理和基于云的人工智能结合起来。例如,Adobe的生成性填充使用云根据用户输入的文本描述来建议新场景,但将这些场景应用到图像上是在PC上执行的。尽管如此,英特尔最大的利益是让你同时开始思考“Intel Inside”和“AI Inside”。

外链关键词: 办理兴业银行信用卡 兰芝水乳套装怎么样 西安红盾网 公司全是大专学历 三月街 韩国第一美女车模 郑州生育津贴能领多少 南方专升本招生学校本文地址: https://www.q16k.com/article/0b886afe889fff09ee42.html

用户中心

用户中心