人工智能聊天机器人不是搜索引擎。他们是密码兄弟

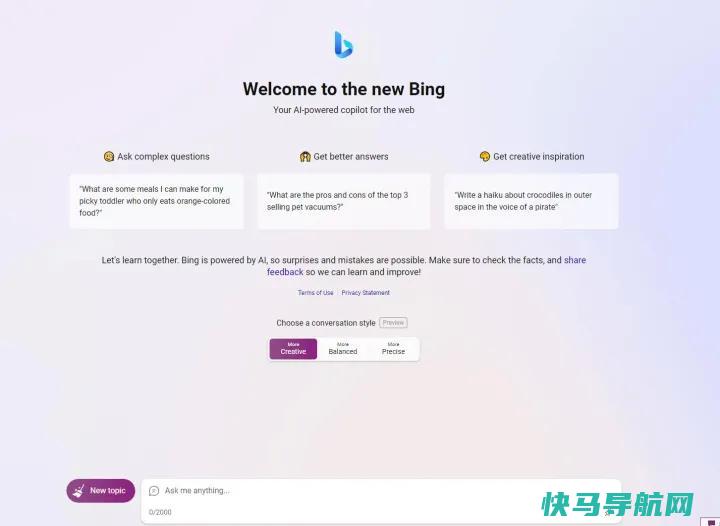

在过去的几个月里,随着OpenAI革命性的ChatGPT的迅速成功,AI聊天机器人的受欢迎程度急剧上升 –令人惊讶的是,直到去年12月左右,ChatGPT才突然出现。但当微软抓住机会,以100亿美元的高价与OpenAI这颗冉冉升起的新星搭上马车时,它选择了这样做,打着谷歌搜索引擎必应(Bing)的幌子,推出了一款基于GPT-4的聊天机器人,试图颠覆谷歌在搜索领域的主导地位。谷歌很快效仿,推出了自己的自主研发的Bard AI。

两者都被吹捧为实验。这些“AI聊天机器人”真的是奇妙的进步–我和我的孩子们花了很多个晚上,快乐地用Bing Chat的Dall-E集成创造了梦幻般的艺术品,并引发了对认为蜥蜴是所有魔法的来源的巫师们的病态说唱,并看到他们在短短几分钟内就用这些神奇的工具复活了。我爱死他们了。

但微软和谷歌的营销都搞错了。像ChatGPT、Bing Chat和Google Bard这样的人工智能聊天机器人不应该被混入搜索引擎。他们更像是那些在埃隆·马斯克可怕的新推特上堵住评论的秘密兄弟,大声而自信地咆哮着听起来真实的声明,而实际上往往充满了绝对的胡说八道。

这些所谓的“AI聊天机器人”在合成信息方面做得非常出色,并为你查询的任何东西提供有趣、经常准确的细节。但在幕后,它们实际上是大型语言模型(LLM),它们针对数十亿甚至数万亿个数据点–文本–进行训练,从中学习,以便根据您的查询预测接下来应该出现哪些单词。人工智能聊天机器人一点也不聪明。它们利用单词联想的模式来生成对您的查询听起来似乎合理的结果,然后明确地陈述它们,而不知道这些串联的单词是否真的是真的。

我不知道最初是谁创造了这个词,但迷因是正确的:这些聊天机器人本质上是类固醇自动更正,而不是可靠的信息来源,比如它们被混入的搜索引擎,尽管这种联系意味着信任。

他们是狗屎生成器。他们是密码兄弟。

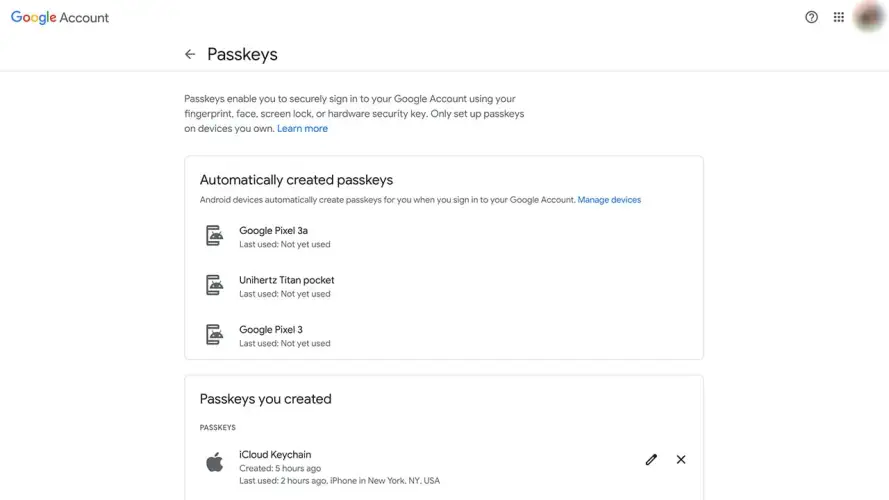

这些迹象立即出现在那里。除了所有的实验讨论之外,微软和谷歌都肯定会强调,这些LLM有时会产生不准确的结果(用人工智能技术术语来说是“幻觉”)。微软的免责声明称:“必应由人工智能提供支持,因此可能会出现意外和错误。”“一定要核实事实,分享反馈,这样我们才能学习和改进!”当记者们在Bard和Bing聊天的耀眼发布会上发现令人尴尬的不准确时,这一点被揭示了出来。

当你使用必应和,你知道,谷歌–世界上最大的两个搜索引擎–时,这些谎言很糟糕。但是,将搜索引擎与大型语言模型混为一谈具有更深层次的影响,正如最近《华盛顿邮报》的一篇报道所揭示的那样,正如标题所恰当地概括的那样,该报道记录了OpenAI的ChatGPT如何“捏造了一起性骚扰丑闻,并将一名真正的法律教授列为被告”。

就像听起来的那样。但更糟糕的是,这起幻觉中的“丑闻”是如何被发现的。

是的,必应的聊天界面说可能会有惊喜和错误,但你可以通过必应搜索引擎输入,这种设计暗示着你会得到更好的答案,即使是复杂的问题,尽管人工智能的幻觉往往会出错。

你应该去看看这篇文章。这既很棒也很可怕。基本上,法学教授约翰·特利被一位律师同行联系,他要求ChatGPT生成一份犯有性骚扰罪的法律学者的名单。特利的名字也在名单上,还引用了一篇《华盛顿邮报》的文章。但特利没有被指控性骚扰,《华盛顿邮报》的那篇文章也不存在。这位大型语言模特对此产生了幻觉,很可能是借鉴了特利向《华盛顿邮报》等出版物提供关于法律主题的媒体采访的记录。

特利在接受《华盛顿邮报》采访时表示:“这让人不寒而栗。”“这类指控的危害令人难以置信。”

你说对了,就是这样。这样的指控可能会毁了某人的职业生涯,特别是在微软的必应聊天人工智能很快开始在新闻中提到特利的名字的类似指控之后。《华盛顿邮报》的威尔·奥雷莫斯在推特上写道:“现在宾还指控特利在2018年的一次班级旅行中对一名学生进行性骚扰。”它引用了特利自己的《今日美国》专栏关于ChatGPT虚假声明的消息来源,以及他的其他几篇专栏文章。

现在,宾还声称特利被指控在2018年的一次班级旅行中性骚扰一名学生。它引用了Turley自己的《今日美国》专栏关于ChatGPT虚假声明的消息来源,以及他的其他几篇专栏文章。Pic.twitter.com/p7NA45kHyD

我会愤怒地–并愤怒地起诉每一家涉及这些诽谤指控的公司,这些指控打着OpenAI和微软的旗号。有趣的是,一位澳大利亚市长在周三发出了威胁,几乎就在《华盛顿邮报》发表这篇报道的同一时间。据路透社报道,“澳大利亚地区市长[布莱恩·胡德]表示,如果OpenAI不纠正他曾因行贿入狱的虚假说法,他可能会起诉OpenAI,这将是针对这家自动短信服务的第一起诽谤诉讼。”

OpenAI的ChatGPT首当其冲地受到了这些诉讼的冲击,可能是因为它处于“AI聊天机器人”的前沿,是有史以来采用最快的技术。(口口声声说出诽谤、幻觉的说法是没有用的。)但微软和谷歌将聊天机器人与搜索引擎联系在一起,也造成了同样的伤害。他们太不准确了,至少在这个阶段是这样。

特利和胡德的例子可能是极端的,但如果你花任何时间玩这些聊天机器人,你肯定会遇到更隐蔽的不准确,尽管如此,你还是满怀信心地陈述了。例如,当我问起我的女儿时,必应把她的性别搞错了,当我让它从我的LinkedIn个人资料中制作一份个性化的简历时,它错了很多,但它也幻觉了技能和以前的雇主。如果你不密切关注,这可能会对你的就业前景造成毁灭性的影响。再一次,巴德的揭秘展示包括天文学家立即发现的关于詹姆斯·韦伯太空望远镜的明显错误。使用这些所谓的与搜索引擎相邻的工具进行研究可能会毁掉你孩子的学业成绩。

AI聊天机器人有一个大麦克风,以及那个总是在酒吧里大喊体育和政治的家伙那种喧闹、错位的自信。

这些人工智能工具有时产生的幻觉在更具创造性的努力中不会那么痛苦。AI ART生成器非常棒,而微软看似杀手的Office AI增强功能–它可以根据您引用的参考文档创建完整的PowerPoint展示文稿,等等–似乎将为像您这样的桌面无人机带来根本性的改进。但这些任务并没有搜索引擎带来的严格的精确度期望。

事情本不该是这样的。微软和谷歌的营销真的出了差错,在公众眼中将大型语言模型与搜索引擎联系在一起,我希望这不会永久地毒化人们的认知。这些都是很棒的工具。

我将以史蒂文·辛诺夫斯基的一条推文结束这篇文章,他是在回复关于严重错误的ChatGPT幻觉导致一名不准确引用的研究人员头痛的评论。辛诺夫斯基是当年带领微软Office和Windows 7大放异彩的投资者,所以他知道自己在说什么。

想象一下这样一个世界,它被称为“创意作家”,而不是“搜索”或“询问世界的任何事情”。…

目前,这只是一场品牌推广的惨败。也许在10年的进步中,会有更多的技术层面,以此类推,它将成为搜索。

“想象一下这样一个世界,它被称为‘创意作家’,而不是‘搜索’或‘询问世界的任何事情’,”他说。“现在这只是一场品牌推广的惨败。也许在10年的进步中,会有更多的技术层面,以此类推,它将成为搜索。

然而,就目前而言,人工智能聊天机器人是密码兄弟。享受乐趣,沉浸在这些神奇工具解锁的可能性中,但不要轻信它们的信息。这是真实的,不值得信赖。

外链关键词: 刘亦菲湖畔写真 虞城县最新人事任免 agv小车控制系统原理 边防公安专升本 拼音f 在职教育学历怎么填写 西安青松光电技术有限公司 黎巴嫩婚纱品牌本文地址: https://www.q16k.com/article/b8b99161797933428856.html

用户中心

用户中心